首发!PPIO派欧云上线DeepSeek-R1-0528-Qwen3-8B蒸馏模型

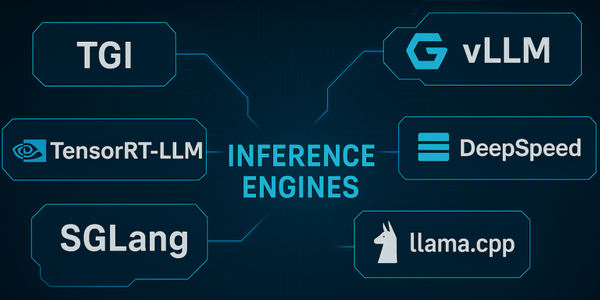

DeepSeek R1 系列的模型更新还在继续。 继昨天 PPIO派欧云首发上线 DeepSeek-R1-0528 模型后,今天 PPIO 再次首发 DeepSeek 最新开源的蒸馏模型 DeepSeek-R1-0528-Qwen3-8B。 DeepSeek-R1-0528-Qwen3-8B 是将 DeepSeek-R1-0528 的思维链提取出来,用于对 Qwen3 8B Base 进行后训练而得到的蒸馏模型。 该 8B 模型在数学测试 AIME 2024 中仅次于 DeepSeek-R1-0528,超越 Qwen3-8B (+10.0%),与 Qwen3-235B 相当。 现在,你可以在 PPIO 平台快速体验该系列模型: https://ppio.cn/llm/deepseek-deepseek-r1-0528-qwen3-8b 同时,DeepSeek-R1-0528-Qwen3-8B 的价格也一并发布: DeepSeek-R1-0528-Qwen3-8B 实测