PPIO上线私有化部署解决方案:按需定制+专用GPU集群,帮助AI企业降本增效

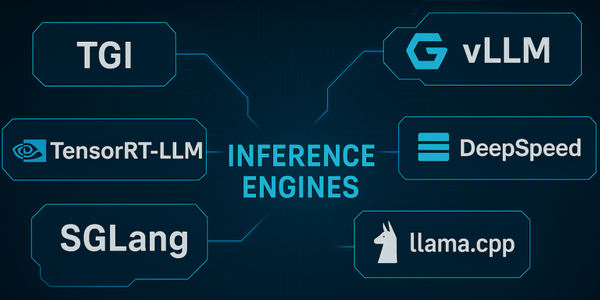

在全球 AI 应用场景爆发式增长、企业级定制需求激增的背景下,PPIO派欧云正式推出针对大语言模型的企业私有化部署解决方案。 作为一款全托管式高性能 AI 私有化部署服务,该解决方案专为需要可靠基础设施、弹性扩展能力及企业级安全保障的团队设计,致力于让企业以更低的成本、更高的效率实现 AI 应用规模化落地。 随着生成式 AI、多模态大模型等技术快速渗透至教育、招聘、车联网、零售、医疗等核心场景,企业对 AI 模型的性能、安全性和可控性提出了更高的要求。 然而,企业如果想要自身进行 AI 部署需要面临多重挑战: 1. 资源成本高:自建 GPU 集群需巨额投入,且资源利用率低下; 2. 运维复杂度高:基础设施维护占用技术团队大量精力,难以聚焦核心业务; 3. 性能波动大:共享资源导致的算力争抢、突发流量引发的响应延迟,直接影响用户体验; 4. 安全合规难:数据与模型的物理隔离需求难以满足,企业敏感信息易暴露风险。 而 PPIO