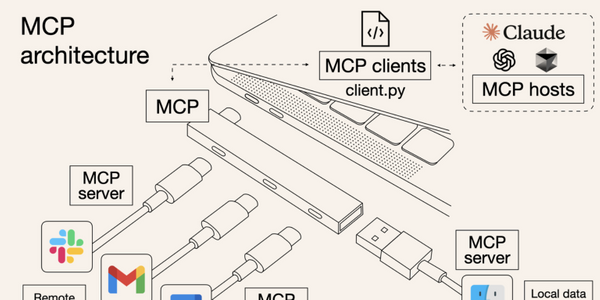

AI圈爆火的MCP,你最需要了解这5个关键问题

近期,一个名为 MCP 的概念正在 AI 圈子里流行,从海外火到了国内。 3 月 27 日,OpenAI 宣布在 Agent SDK 中支持 MCP;4 月 4 日,谷歌宣布在 Gemini 的官方 API 文档中添加使用 MCP 的范例。加上此前提出 MCP 协议的 Anthropic,海外三大 AI 巨头已经全部投入 MCP 怀抱。 国内也迅速跟进,阿里云百炼上线业界首个全生命周期 MCP 服务,腾讯云支持 MCP 插件托管服务,MiniMax 发布了 MCP Server......MCP 似乎在一夜之间变成