PPIO首发上线DeepSeek-V3.1,Agent 能力大幅提升

刚刚,DeepSeek 正式发布 DeepSeek-V3.1,该模型相比此前 DeepSeek 系列模型拥有更高的思考效率和更强的 Agent 能力,在工具使用与智能体任务中的表现大幅提升。

DeepSeek-V3.1 采用混合推理架构,同时支持思考模式与非思考模式,且官方上下文均已扩展为 128K。经 PPIO 优化后,DeepSeek-V3.1 上下文长度可拓展至 160k,处理长文本及复杂问题的能力进一步增强。

快速入口:

https://ppio.com/llm/deepseek-deepseek-v3.1

模型特征

- 工具调用/智能体支持增强

据 DeepSeek 官方发布消息,通过 Post-Training 优化,DeepSeek-V3.1 拥有更强工具调用和任务处理能力。

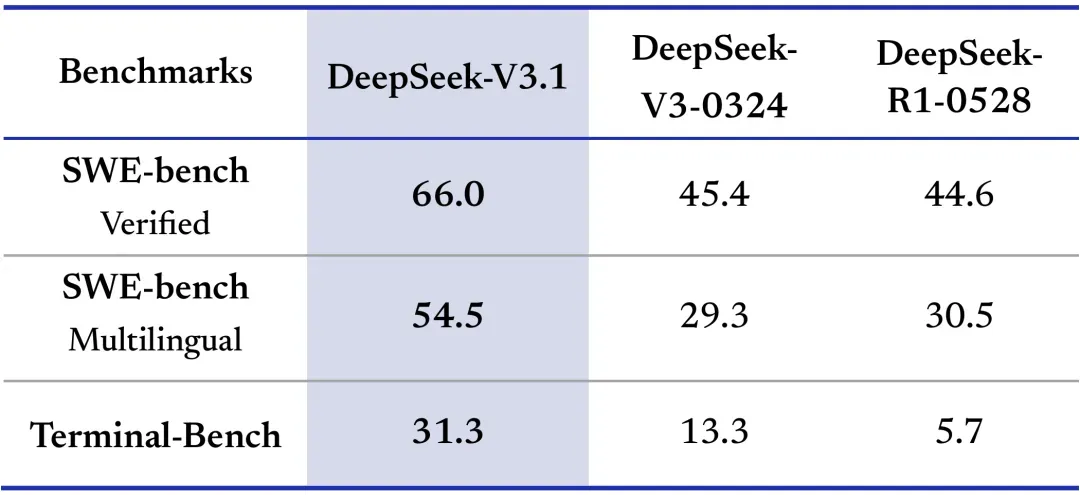

在代码修复测评 SWE 与命令行终端环境下的复杂任务(Terminal-Bench)测试中,DeepSeek-V3.1 相比之前的 DeepSeek 系列模型有明显提高。

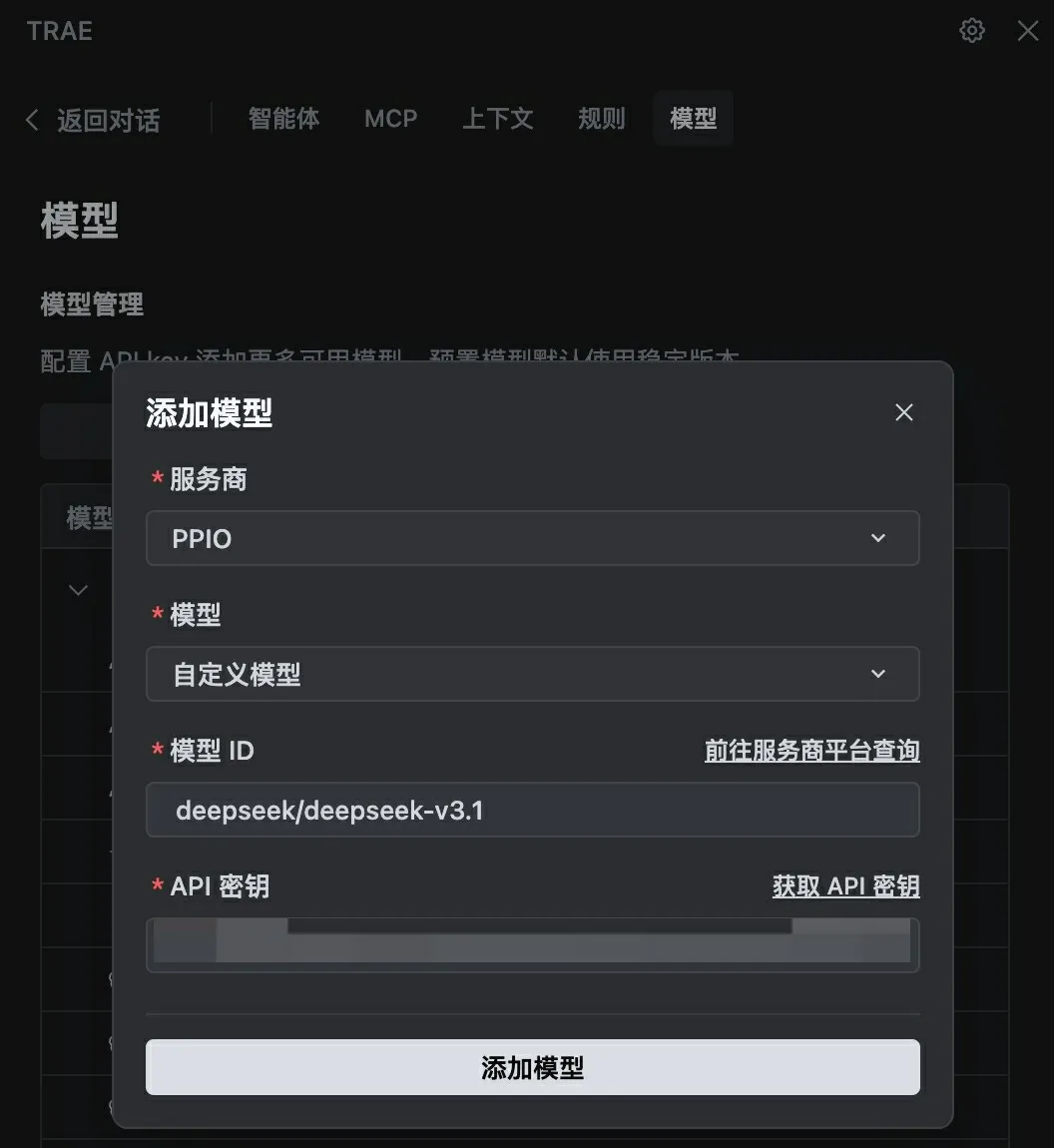

我们尝试在 Trae 中调用 PPIO 提供的 DeepSeek-V3.1 模型 API,进行前端代码编写,得到的页面交互流畅自然,信息架构逻辑性强。

- 思考效率提升

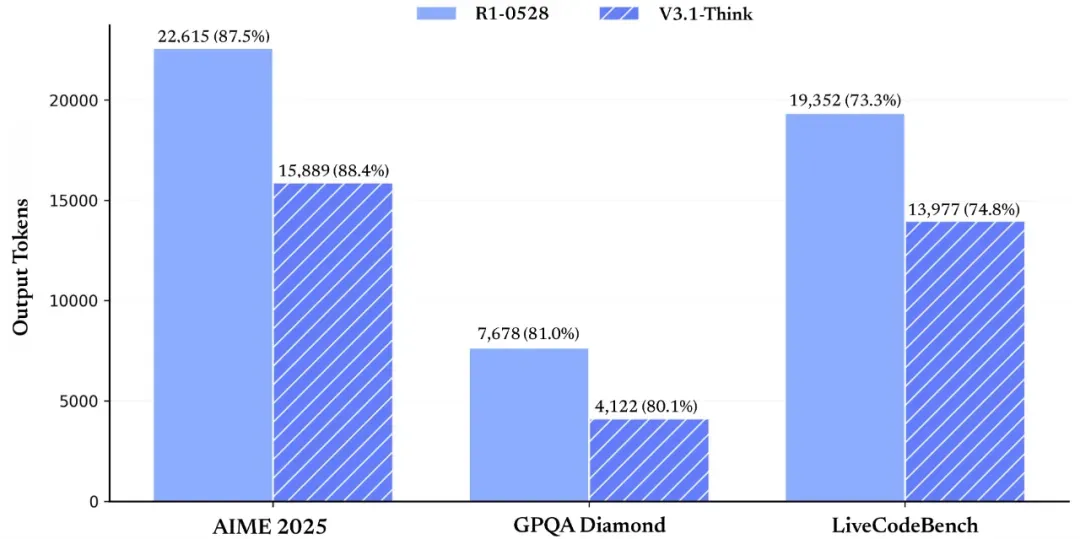

相比 DeepSeek-R1-0528,DeepSeek-V3.1-Think 在输出 token 数减少 20%-50% 的情况下,各项任务的平均表现与 R1-0528 持平,且能在更短时间内给出答案。同时,非思考模式下的输出长度也明显减少,并保持相同的模型性能。

现在,PPIO已支持接入Trae,只需简单配置,就可以在Trae中调用PPIO提供的DeepSeek-V3.1模型API,体验DeepSeek V3.1的编程能力。

模型ID:deepseek/deepseek-v3.1

PPIO 一直致力于为企业和开发者提供更高性能的模型 API 服务,帮助企业将先进技术快速集成到企业现有的工作流程中。