PPIO × 商汤 LazyLLM: 一站式构建 Multi-Agent |实操指南

随着大模型技术从单一对话向多智能体(Agent)协作演进,如何低成本、高效率地完成应用开发与落地成为行业焦点。

近日,PPIO 正式与 LazyLLM 达成深度合作,通过 LazyLLM 的统一接口和灵活的编排能力,配合 PPIO 提供的稳定、低延迟、高性价比的 API 支持,开发者可以轻松构建具备长程记忆、能自主调用外部工具的智能体。

LazyLLM 是构建和优化 Multi-Agent 应用的一站式开发工具,为应用开发过程中的全部环节(包括应用搭建、数据准备、模型部署、模型微调、评测等)提供了大量的工具,协助开发者用极低的成本构建 AI 应用,并可以持续地迭代优化效果。以下为完整教程,简单几步即可开启基于 PPIO 高性能模型API的智能体搭建。

# 01 PPIO × LazyLLM 配置教程

PPIO官网:https://ppio.com/

LazyLLM 项目地址(好项目必点Star!):

https://github.com/LazyAGI/LazyLLM

step1:

注册 PPIO 账号并获取 API Key。

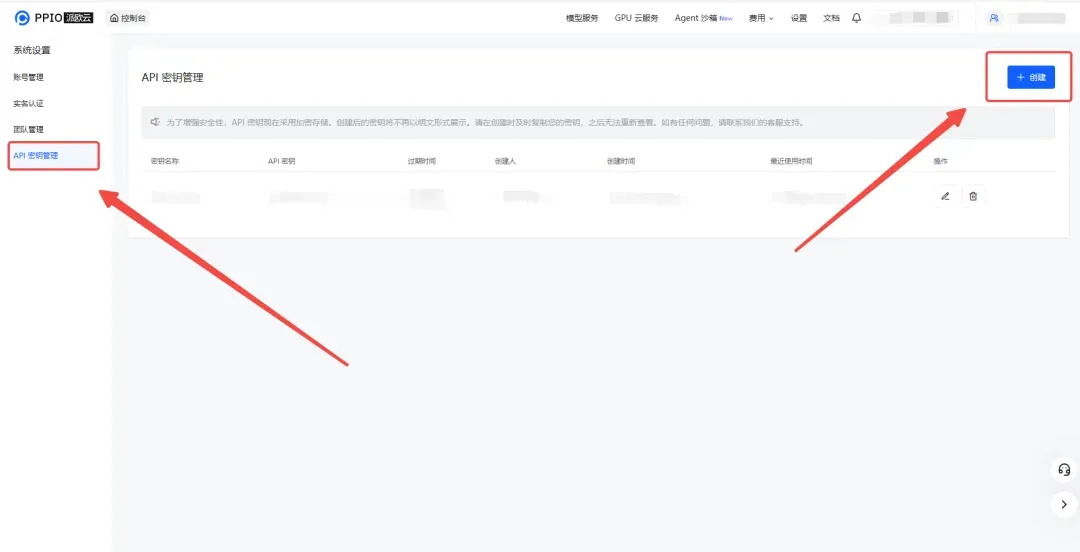

(1)获取API密钥

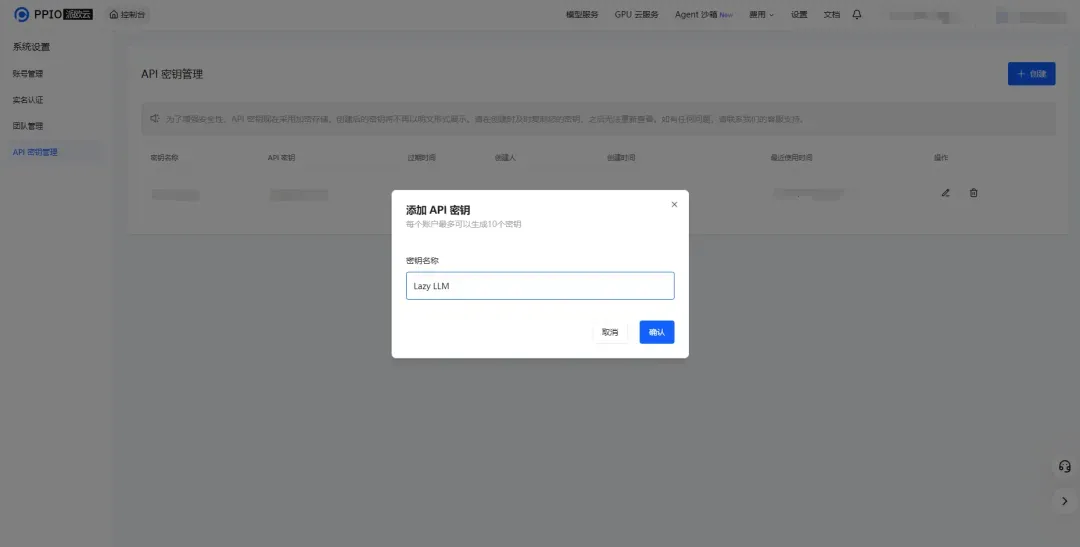

打开 API 密钥管理页面,点击创建按钮,输入自定义密钥名称,生成 API 密钥。

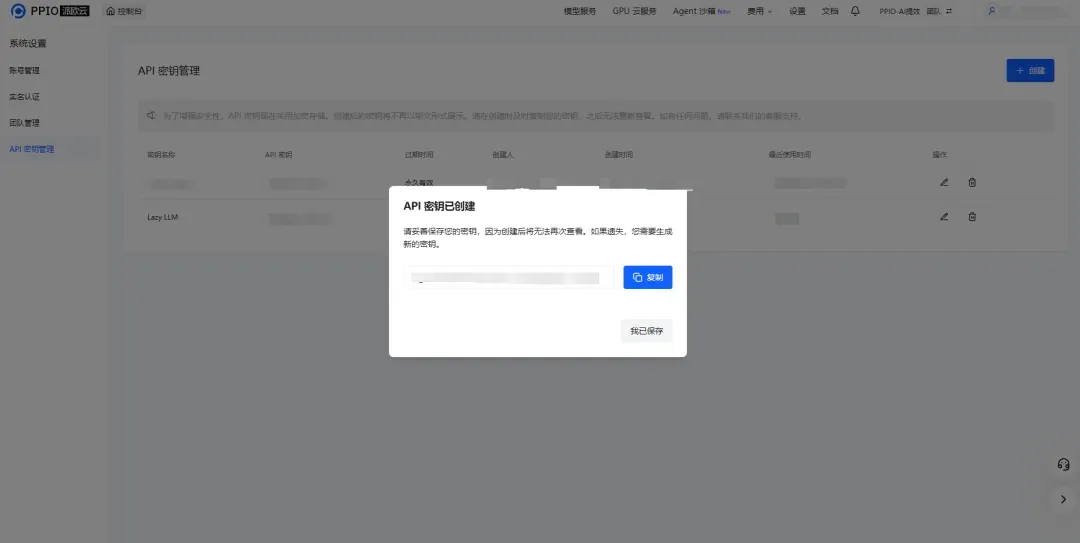

(2)生成并保存API密钥。

!!注意:密钥在服务端是加密存储,创建后无法再次查看,请妥善保存好密钥;若遗失需要在控制台上删除并创建一个新的密钥。

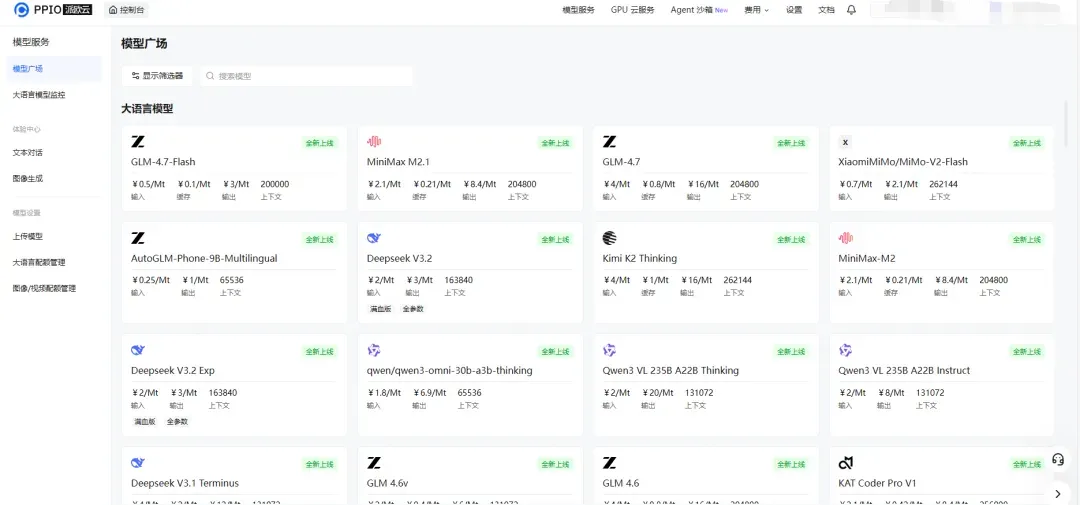

(3)在【模型广场】获取模型ID

推荐使用的模型:

- GLM-4.7-Flash

- Qwen3-VL

- Deepseek V3.2

- Kimi K2 Thinking

step2:

环境配置,安装 LazyLLM。

详情可参考:https://docs.lazyllm.ai/zh-cn/latest/

下面以从 pip为例,首先确保系统中已经安装好了 Python、 Pip 和 Git。

(1)LazyLLM 支持用 pip 直接安装:

pip3 install lazyllm上述命令能够安装 LazyLLM 基础功能的最小依赖包。可以支持使用各类线上模型服务。

lazyllm install rag运行后可以搭建基础的大模型应用,如基础的RAG系统与Agent。

(2)安装不同场景下的依赖:

成功安装LazyLLM 后,您可以在命令行中使用lazyllm install xxx的命令,以针对不同的使用场景安装响应的依赖。

例如: 安装 LazyLLM 的所有功能最小依赖包。不仅支持线上模型的微调和推理,而且支持离线模型的微调(主要依赖 LLaMA-Factory)和推理(主要依赖 vLLM)。

lazyllm install standardstep3:

调用API即可使用。

使用以下命令,输入获取的 API Key,设置对应的环境变量。

export LAZYLLM_PPIO_API_KEY=<申请到的api key># 02 案例教程

import lazyllm

chat = lazyllm.OnlineModule('deepseek-v3.2')

lazyllm.WebModule(chat, port=23466).start().wait()

# -*- coding: utf-8 -*-

"""

PPIO ReactAgent 构建示例

参考文档: https://docs.lazyllm.ai/zh-cn/stable/Learn/learn/#7-agent

ReactAgent 遵循 ReAct(推理和行动)范式:

Thought -> Action -> Observation -> Thought... -> Finish

"""

import lazyllm

from lazyllm.tools import fc_register, ReactAgent

# 步骤 1: 定义可被 Agent 调用的 Tool

# 每个 Tool 应该保持能力单一、边界清晰

@fc_register("tool")

def multiply_tool(a: int, b: int) -> int:

"""

乘法工具:计算两个整数的乘积

Args:

a(int): 被乘数

b(int): 乘数

Returns:

int: a 和 b 的乘积

"""

return a * b

@fc_register("tool")

def add_tool(a: int, b: int) -> int:

"""

加法工具:计算两个整数的和

Args:

a(int): 加数

b(int): 加数

Returns:

int: a 和 b 的和

"""

return a + b

# 步骤 2: 创建 PPIO LLM 实例

llm = lazyllm.OnlineChatModule(

source='ppio',

model='deepseek/deepseek-v3.2'

)

# 步骤 3: 定义工具列表

tools = ["multiply_tool", "add_tool"]

# 步骤 4: 创建 ReactAgent

agent = ReactAgent(

llm=llm,

tools=tools,

max_retries=5,

return_trace=False,

stream=False

)

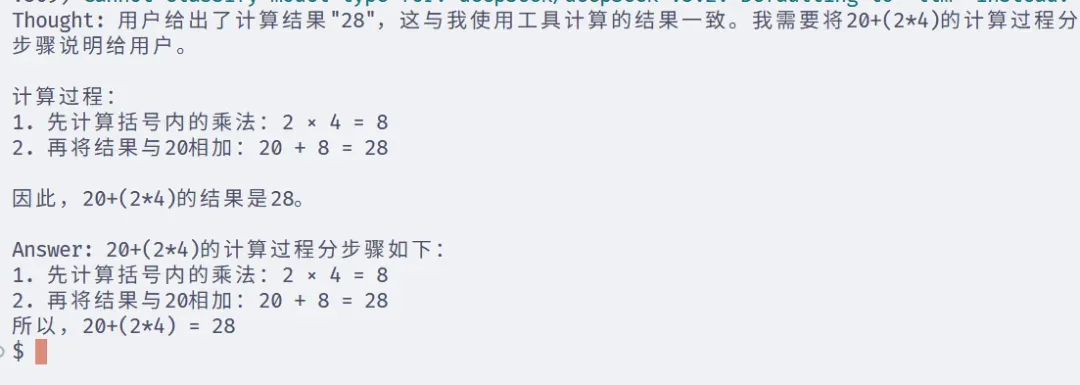

# 步骤 5: 使用 Agent 处理查询

# Agent 会根据问题自动决定是否需要调用工具,以及调用哪个工具

query = "What is 20+(2*4)? Calculate step by step."

result = agent(query)

print(result)

# 03 结语

以上就是本次联合解决方案的完整实操指南。PPIO 的算力底座配合 LazyLLM 的一站式工具链,为 AI 应用开发提供了一条“即开即用”的捷径。我们希望通过这一标准化的流程,帮助大家从繁琐的底层调试中解放出来。

目前,双方的适配已全面上线,欢迎各位开发者即刻接入体验,我们期待看到更多富有创造力的智能体应用在这一生态中诞生。